「AIって便利そうだけど、なんだか怖い…」

「個人情報とか会社の機密情報を入力しても大丈夫なの?」

ChatGPTをはじめとする生成AIの進化は、私たちの仕事や生活を劇的に変える可能性を秘めています。しかしその一方で、使い方を間違えると、あなたの重要な情報が意図せず漏洩してしまったり、AIが生成したもっともらしい「嘘」に騙されてしまったりする危険性も潜んでいます。

この記事では、AIを安全かつ効果的に活用するために、すべてのAI初心者が知っておくべき「セキュリティ対策」と「ハルシネーション(AIの嘘)対策」について、動画の内容に基づき、スクリーンショットを交えながら具体的かつ丁寧に解説します。このマニュアルを読めば、あなたも今日から安心してAIを使いこなせるようになるはずです。

第1章:あなたの情報を守る!生成AIのセキュリティ対策

まず最も重要なのが、情報漏洩を防ぐためのセキュリティ対策です。気づかないうちに、あなたが入力した情報がAIの学習に使われ、世界中に公開されてしまうリスクがあります。

なぜセキュリティ対策が必要なのか?

ChatGPTのような生成AIは、より賢く、より良いサービスを提供するために、ユーザーが入力した情報を「学習」する仕組みを持っています。これは、AIの性能向上には不可欠なプロセスです。

しかし、もしあなたが顧客の個人情報や社外秘のプロジェクト情報などを入力してしまったらどうなるでしょうか?それらの機密情報もAIの学習データとして取り込まれ、他のユーザーへの回答を生成する際に、意図せず利用されてしまう可能性がゼロではないのです。これは、極端に言えば情報漏洩のリスクがあることを意味します。

具体的には、以下のような情報の入力は絶対に避けるべきです。

- 顧客名、電話番号、メールアドレス、住所などの個人情報

- 未公開の新製品情報や経営戦略などの社内機密情報

- その他、外部に漏れるべきではないあらゆる情報

【実践】ChatGPTで情報学習をオフにする方法

幸いなことに、ChatGPTには、入力した情報をAIの学習に利用させないようにする設定が用意されています。個人で利用している方は、この設定がオンになっている可能性が高いため、必ず確認・変更してください。

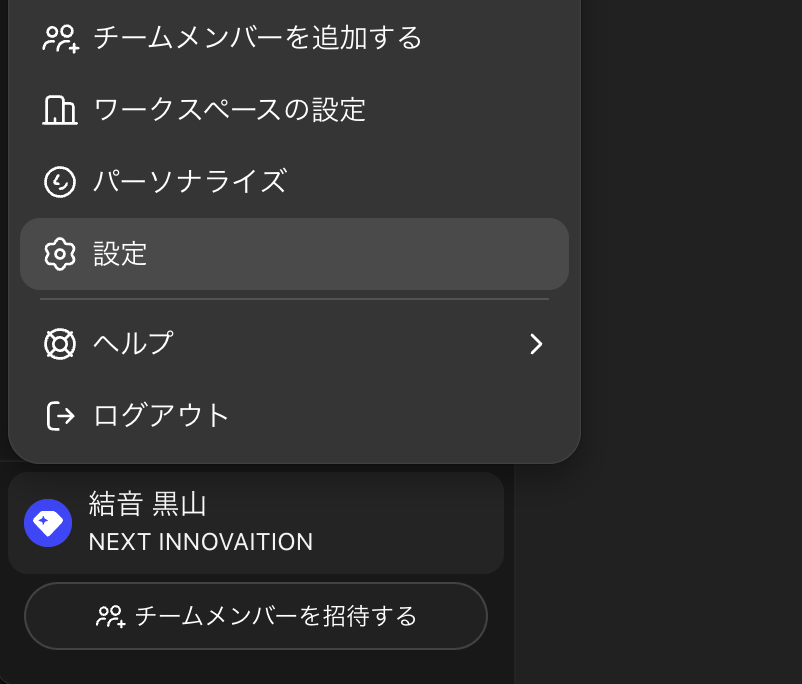

手順1:設定画面を開く

まず、ChatGPTの画面左下にあるあなたのアカウント名をクリックし、表示されるメニューから「設定(Settings)」を選択します。

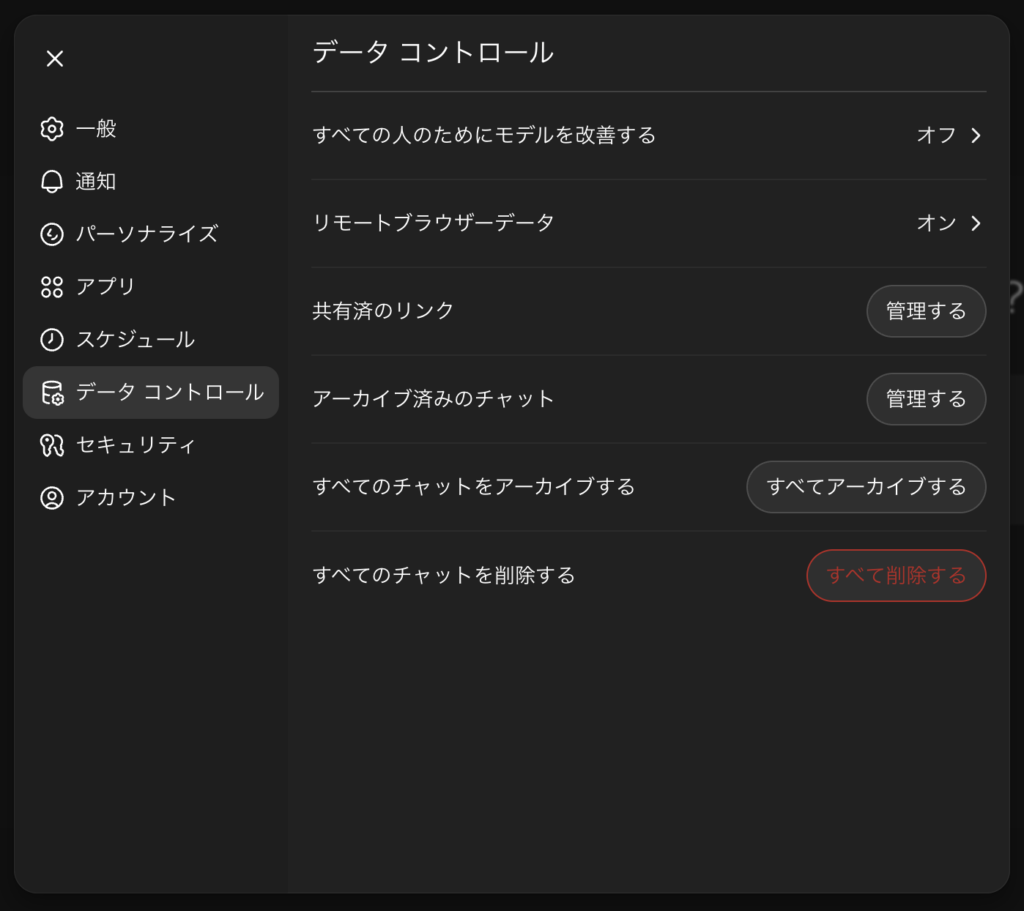

手順2:「データコントロール」を選択

設定画面が開いたら、左側のメニューから「データコントロール(Data controls)」を選択します。

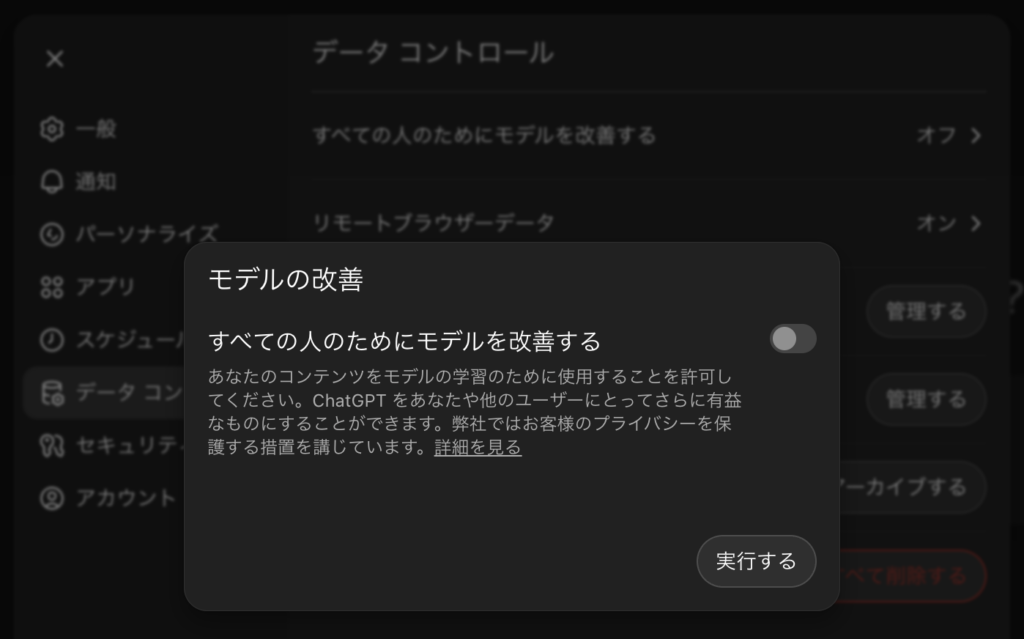

手順3:「モデルの改善」をオフにする

「すべての人のためにモデルを改善する(Improve the model for everyone)」という項目があります。これがAIの学習に関する設定です。このトグルスイッチをオフにしてください。

初期設定ではこの項目がオンになっているため、あなたの会話データがモデルの学習に使用されてしまいます。必ずオフにしておきましょう。

補足:ビジネスプランの場合

ChatGPTのビジネスプランを利用している場合、この設定はデフォルトでオフになっており、入力情報が学習に使われることはありません。

設定をオフにすれば万全?

では、この設定をオフにさえすれば、どんな情報を入力しても絶対に安全なのでしょうか?

「そんなことはない」というのが私の見解です。過去にLINEやGoogleのような大企業でさえ情報漏洩が起きたように、どのようなサービスであっても情報漏洩のリスクが100%ないとは言い切れません。AIも例外ではなく、システム的な脆弱性など、予期せぬ形で情報が漏れる可能性は常に存在します。

したがって、たとえ学習をオフにする設定をしていても、「これはさすがに外部に漏れたらまずい」という機密性の高い情報は、そもそも入力しないという心構えが非常に重要です。

第2章:AIの「嘘」を見破る!ハルシネーション対策

セキュリティ対策と並んで重要なのが、AIが生成する「嘘」への対策です。AIは時として、事実に基づかないもっともらしい情報を生成することがあり、これをハルシネーションと呼びます。

AIはなぜ「嘘」をつくのか?

AIは、私たちを騙そうとして悪意を持って嘘をついているわけではありません。ハルシネーションが起こる主な原因は、AIの仕組みそのものにあります。

- 推測による情報の補完

AIは、学習データの中に明確な答えが見つからない場合でも、文脈から「おそらくこうだろう」と推測して、情報の欠落部分を自ら創作して埋めようとします。この推測が間違っていた場合に、結果として「嘘」が生まれます。 - 学習データ自体の誤り

AIは、インターネット上の膨大なテキストデータなどを学習しています。もし、その学習データ自体に間違った情報や古い情報が含まれていた場合、AIはそれを正しい情報として学習してしまい、誤った回答を生成してしまいます。

【実践】AIに嘘をつかせない「魔法の呪文(プロンプト)」

ハルシネーションのリスクを完全にゼロにすることは困難ですが、プロンプト(AIへの指示文)を工夫することで、その確率を大幅に下げることができます。動画で紹介されていた、調査系のタスクで特に有効なプロンプトがこちらです。

<web_search_rules>

- 事実が不確かな場合は推測せずWebで確認し、根拠に引用を付ける

- 複数ソースで重要点をクロスチェックし、矛盾があれば整理して結論を出す

- 追加調査の価値が逓減するまで掘る(ただし脱線はしない)

- 質問で止めず、想定される意図を網羅して答える

- 出力はMarkdownで、定義→要点→比較→具体例の順に整理

</web_search_rules>このプロンプトを、何か調べ物を依頼する際に冒頭に入れるだけで、AIはより慎重かつ正確に回答を生成しようとします。

- 「事実が不確かな場合は推測せず〜」: AIが得意な「推測」を禁じ、事実に基づいた回答を要求します。

- 「複数ソースで重要点をクロスチェックし〜」: 一つの情報源を鵜呑みにせず、情報の信頼性を高めるよう指示します。

出力形式をコントロールして、さらに使いやすく

上記のプロンプトの最後に「出力はMarkdownで〜」という一文があります。これは、回答のフォーマットを指定するものです。

- Markdown形式: 見出しや箇条書き、太字などを使った構造的な文章を生成します。ブログ記事やレポート作成の際にそのままコピー&ペーストできて便利です。

- テキスト形式: 装飾のない、プレーンなテキストを生成します。メールやチャットで内容を共有したい場合に適しています。

もし、LINEで送ったり、X(旧Twitter)に投稿したりするなど、装飾が不要な場合は、プロンプトの最後の部分を「出力はテキスト形式で」のように変更すると、より扱いやすい回答が得られます。

最終的には「自分の頭」で判断を

これらの対策を講じることで、AIの回答の信頼性は格段に向上します。しかし、それでもハルシネーションのリスクが完全に消えるわけではありません。

最終的にその情報が本当に正しいかどうかを判断するのは、AIではなく、私たち人間です。特に重要な意思決定にAIの回答を利用する際は、必ず複数の情報源を確認するなど、ファクトチェックを怠らないようにしましょう。

まとめ

本マニュアルでは、生成AIを安全に利用するための「セキュリティ対策」と「ハルシネーション対策」について解説しました。

| 対策項目 | 具体的なアクション |

|---|---|

| セキュリティ対策 | ChatGPTの設定で、モデルの学習をオフにする。機密情報は入力しない。 |

| ハルシネーション対策 | AIに嘘をつかせにくくするプロンプトを活用する。最終的には自分でファクトチェックを行う。 |

これらのポイントをしっかりと押さえることで、あなたは情報漏洩や誤情報のリスクを最小限に抑え、AIという強力なツールの恩恵を最大限に享受することができるようになります。ぜひ今日から実践してみてください。

コメント